Google publikoi detaje rreth një prej superkompjuterëve të saj të inteligjencës artificiale të mërkurën, duke thënë se është më i shpejtë dhe më efikas se sistemet konkurruese Nvidia, pasi modelet e të mësuarit të makinerive të etur për energji vazhdojnë të jenë pjesa më e nxehtë e industrisë së teknologjisë.

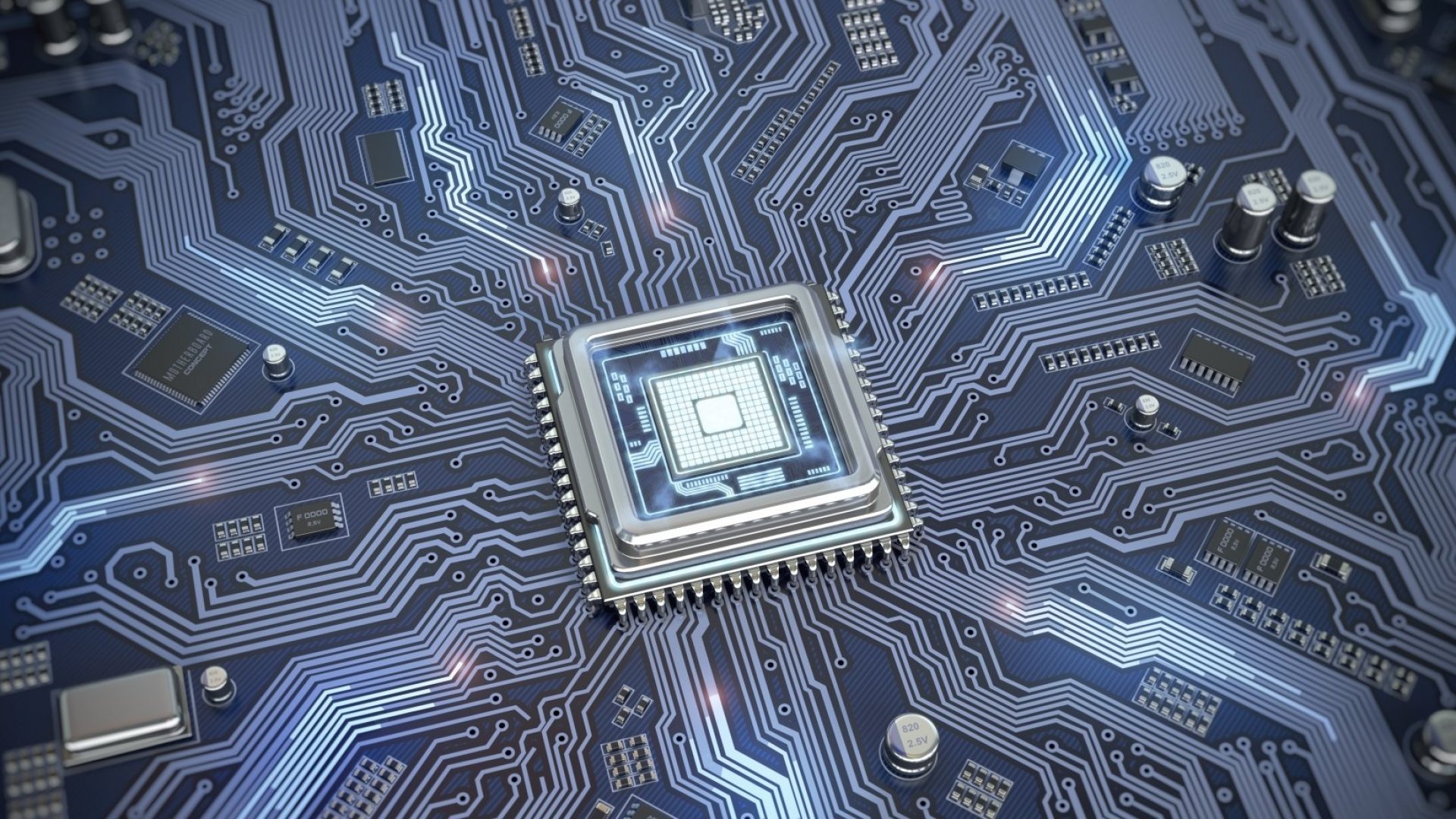

Ndërsa Nvidia dominon tregun për trajnimin dhe vendosjen e modeleve të AI, me mbi 90%, Google ka projektuar dhe vendosur çipa të AI të quajtura Njësitë e Përpunimit Tensor, ose TPU, që nga viti 2016. Google është një pionier i madh i AI dhe punonjësit e tij kanë zhvilluar disa nga përparimet më të rëndësishme në këtë fushë gjatë dekadës së fundit.

Por disa besojnë se ka mbetur prapa për sa i përket komercializimit të shpikjeve të saj, dhe nga brenda, kompania ka qenë në garë për të nxjerrë produkte dhe për të provuar se nuk e ka shpërdoruar drejtimin e saj, një situatë “kodi i kuq” në kompani, raportoi më parë CNBC.

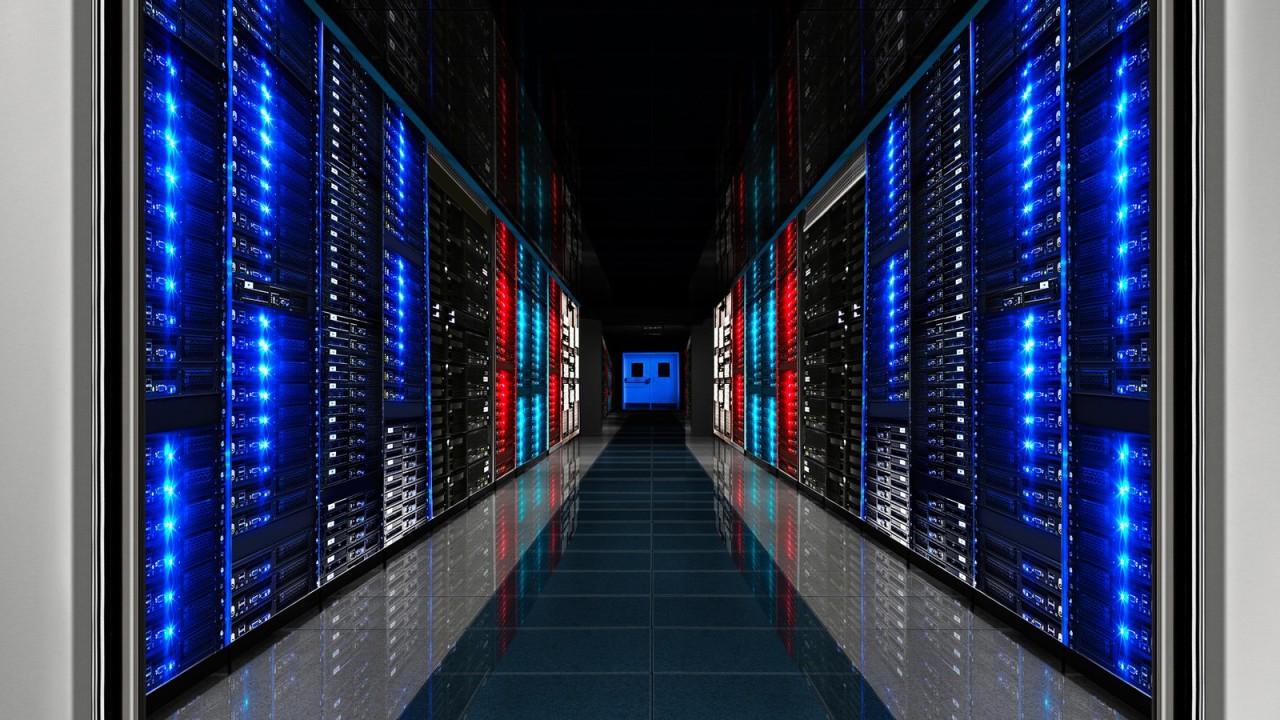

Modelet dhe produktet e AI si Bard i Google ose ChatGPT i OpenAI – i mundësuar nga çipat A100 të Nvidia, kërkojnë shumë kompjuterë dhe qindra ose mijëra çipa për të punuar së bashku për të trajnuar modelet, me kompjuterët që funksionojnë gjatë gjithë orës për javë ose muaj.

Të martën, Google tha se kishte ndërtuar një sistem me mbi 4,000 TPU të bashkuar me komponentë të personalizuar të krijuar për të drejtuar dhe trajnuar modele të AI. Ai funksionon që nga viti 2020 dhe është përdorur për të trajnuar modelin PalM të Google, i cili konkurron me modelin GPT të OpenAI, mbi 50 ditë.

Superkompjuteri i bazuar në TPU i Google, i quajtur TPU v4, është “1.2x-1.7x më i shpejtë dhe përdor 1.3x-1.9x më pak energji se Nvidia A100”, shkruajnë studiuesit e Google. Studiuesit shpjeguan:

Performanca, shkallëzueshmëria dhe disponueshmëria i bëjnë superkompjuterët TPU v4 kuajt e punës së modeleve të mëdha gjuhësore.

Megjithatë, rezultatet TPU të Google nuk u krahasuan me çipin më të fundit Nvidia AI, H100, sepse është më i fundit dhe është bërë me teknologji më të avancuar prodhimi, thanë studiuesit e Google.

Sasia e konsiderueshme e fuqisë kompjuterike të nevojshme për AI është e shtrenjtë dhe shumë në industri janë të përqendruar në zhvillimin e çipave të rinj, komponentëve të tillë si lidhjet optike ose teknikave softuerike që reduktojnë sasinë e energjisë së nevojshme kompjuterike.

Kërkesat për energji të AI janë gjithashtu një ndihmë për ofruesit e reve kompjuterike si Google, Microsoft dhe Amazon, e cila mund të japë me qira përpunimin kompjuterik me orë dhe të sigurojë kredite ose kohë llogaritëse për startup-et për të ndërtuar marrëdhënie.